SUBPROYECTO 2:

Restauración de voz

con interfaces silenciosas

cerebrales

Una de las habilidades más esenciales para el ser humano, nuestra capacidad de hablar, puede verse afectada tras lesiones traumáticas o enfermedades neurodegenerativas como la esclerosis lateral amiotrófica, una enfermedad que se espera que aumente globalmente en un 69% entre 2015 y 2040 debido al envejecimiento de la población y a la mejora de la sanidad pública. A medida que esta enfermedad progresa, las personas que la padecen dejan de poder comunicarse verbalmente y requieren del uso de dispositivos que dependen de señales no verbales para comunicarse. En última instancia, algunas de estas enfermedades pueden dejar al individuo en un estado conocido como síndrome de enclaustramiento, en el que las capacidades cognitivas del individuo están intactas pero éste no puede moverse o comunicarse verbalmente debido a la parálisis completa de casi todos los músculos voluntarios del cuerpo.

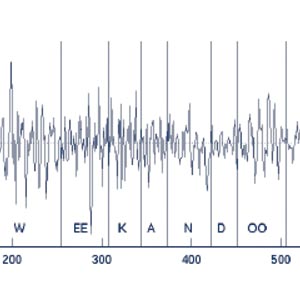

En este proyecto pretendemos investigar el uso de las Interfaces de Habla Silenciosa (SSI) para restaurar la comunicación verbal a estas personas. Las Interfaces de Habla Silenciosa son dispositivos que capturan señales biológicas no acústicas generadas durante el proceso de producción de voz y las utilizan para descifrar las palabras que el individuo quiere transmitir. Mientras que las SSIs han sido investigadas principalmente en el contexto del reconocimiento automático de voz, este proyecto se centra en técnicas de síntesis de voz directa, generando así voz audible directamente a partir de esas bioseñales.

Más específicamente, en este proyecto se pretende desarrollar una prótesis neural en la que se utilizarán señales electrofisiológicas captadas de la corteza cerebral mediante métodos invasivos (electrocorticografía) para decodificar el habla. En trabajos anteriores se ha demostrado la viabilidad de esta propuesta para el caso de algoritmos de reconocimiento automático de voz entrenados en grabaciones de actividad neuronal. En esta propuesta queremos dar un paso más allá e investigar sobre la generación de voz directamente a partir de la actividad neuronal, lo que posibilitaría la síntesis de voz de forma instantánea. Además, como consecuencia de la plasticidad cerebral y de la retroalimentación acústica, también existe la posibilidad de que los usuarios pudiesen aprender a producir una mejor habla con el uso continuo de la prótesis. Para transformar las señales neuronales en audio utilizaremos los últimos avances en sensores de actividad cerebral, síntesis del habla y técnicas de aprendizaje profundo.

Durante el proyecto se generarán bases de datos de actividad neural y señales de voz que se pondrán a disposición de la comunidad investigadora. Además, se desarrollarán nuevas técnicas de aprendizaje profundo.

El proyecto se llevará a cabo con la colaboración de un panel de expertos nacionales e internacionales en los campos del aprendizaje automático y las interfaces de voz silenciosa. Como resultado de este proyecto esperamos iniciar una investigación innovadora cuyo objetivo final es tener un impacto real en las vidas de aquellas personas con graves problemas de comunicación, permitiéndoles restaurar o mejorar la forma en que se comunican.

Objetivos del proyecto

Proyecto coordinado (SP1 + SP2)

- Explorar los caminos y avances en la aplicación de arquitecturas de redes neuronales generativas profundas de última generación para mejorar la calidad actual y la inteligibilidad de los SSI actuales utilizando EMG y ECoG.

- Desarrollar corpus, bases de datos, protocolos y mejores prácticas para la investigación de SSI en idioma español.

- Establecer una nueva línea de investigación y, en consecuencia, una infraestructura de investigación para la ISS en España.

- Fortalecer los vínculos entre dos de los grupos de investigación en tecnologías del habla más consolidados a nivel nacional: Aholab de la UPV / EHU y SiGMAT de la UGR.

Objectivos del SP2

- Grabar el primer corpus de datos a gran escala en español con (a) grabaciones paralelas de habla y de la actividad de los nervios intracraneales y (b) grabaciones no paralelas para el habla imaginada con solo señales cerebrales.

- Desarrollar un sistema de referencia de ECoG a voz de alta calidad entrenado con grabaciones de datos paralelas para sintetizar el habla continua a partir de grabaciones de la actividad neuronal de la corteza motora.

- Investigar el uso del aprendizaje por transferencia para adaptar modelos DNN entrenados previamente con datos paralelos para la tarea de sintetizar el habla imaginada.

- Investigar algoritmos novedosos para el entrenamiento DNN con datos no paralelos para la tarea de síntesis de voz directa a partir de voz imaginada.